Algoritmos, política y tecnología

Imágenes desarrolladas por tecnologías de inteligencia artificial (IA) fueron el boom de las redes durante la semana pasada. Hace pocos días, el sistema más avanzado de la actualidad, Chat GPT, está disponible en nuestro país. La IA se encuentra en boca, pantallas y teclados de todos. En esta nota, hacemos una aproximación hacia qué es y cómo interactuar con estas nuevas aplicaciones científicas.

Por Laura Ruiz Díaz. Las imágenes fueron generadas a través de la IA Midjourney.

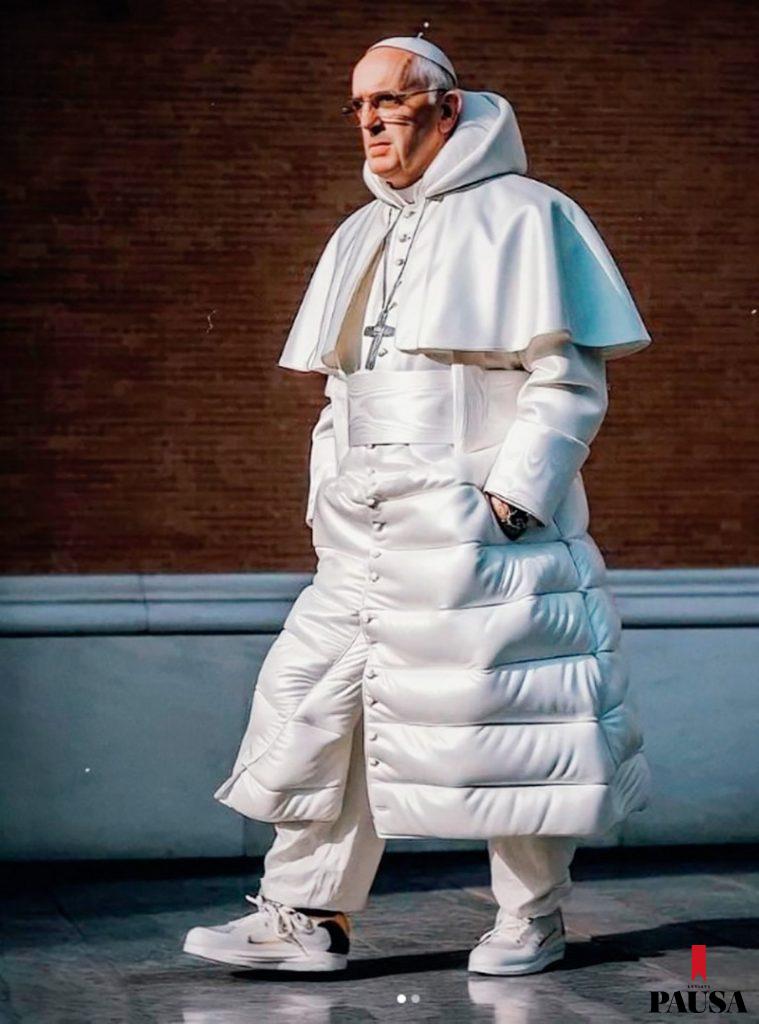

¿Qué tienen en común cientos de fotos del papa Francisco con distintas versiones de un abrigo puffer y el expresidente estadounidense Donald Trump detenido? Ambas fueron creadas por una tecnología de inteligencia artificial (IA) denominada Midjourney. ¿Cómo? El usuario simplemente instruye a la herramienta por medio de un texto que esta interpreta para crear una imagen que, aunque bastante imperfecta, puede sorprender a algunos incautos.

Pero volvamos al origen. La inteligencia artificial es un campo de la informática que se centra en la creación de sistemas capaces de realizar tareas que normalmente requieren de raciocinio humano, como la percepción visual, el reconocimiento del habla, la toma de decisiones y la comprensión del lenguaje natural. Retrocedamos unos 70 años para hablar de su nacimiento, cuando los investigadores comenzaron a desarrollar técnicas para imitar el razonamiento en máquinas.

Uno de los primeros hitos importantes en la historia de la inteligencia artificial fue el desarrollo del programa informático Logic Theorist por Allen Newell y Herbert A. Simon en 1955. Fue capaz de demostrar teoremas matemáticos mediante la utilización de reglas de inferencia lógica, lo que demostró que las máquinas podían realizar tareas complejas que anteriormente se consideraban exclusivas de los seres humanos.

Y no podemos dejar de mencionar al programa de ajedrez Deep Blue, desarrollado por IBM, que derrotó al campeón mundial de la disciplina, Garry Kasparov, en una partida en 1997. Este logro demostró que las máquinas podían superar a los humanos en juegos estratégicos complejos.

Desde entonces la industria creció y hoy existen desde sistemas de reconocimiento de voz y chatbots hasta softwares de conducción autónoma y diagnóstico médico. Si el lector esperaba una nota futurística y cyberpunk… Bueno, un poco es, pero no como las películas de robots y autos voladores.

En este artículo, entrevistamos a la herramienta de inteligencia artificial Chat GPT, desarrollada por Open AI, sobre su origen, y nos sorprendimos con su capacidad de procesamiento de texto. Pero de ninguna manera nos quedamos ahí. Decidimos complementar la nota con voces (humanas) autorizadas para abarcar otras dimensiones de esta nueva tecnología: el estado de la ciencia, la seguridad, los usos y aplicaciones, e inclusive las dimensiones éticas y filosóficas de este tema tan apasionante.

¿Cómo nació Chat GPT?

Chat GPT: – El modelo GPT (Generative Pre-trained Transformer) en el que se basa esta IA fue desarrollado por un equipo de investigadores de OpenAI en 2018 con el objetivo de mejorar la capacidad de las máquinas para entender el lenguaje natural.

Los investigadores de OpenAI utilizaron un enorme conjunto de datos de texto, que incluía libros, artículos de noticias, sitios web y otros recursos en línea. Al alimentar el modelo con esta gran cantidad de datos, se mejoró su capacidad para entender y generar lenguaje natural de manera más precisa.

Desde su lanzamiento en el año 2018, el modelo ha sido actualizado y mejorado en varias ocasiones, lo que llevó a mejoras significativas en su capacidad para realizar tareas de lenguaje natural, como responder preguntas, generar texto coherente y mantener conversaciones naturales, como en el caso de Chat GPT.

¿Qué profesionales conformaron el equipo de desarrollo de esta IA?

GPT: – El equipo de investigación y desarrollo detrás del modelo GPT y, por lo tanto, de Chat GPT, es un grupo de expertos en inteligencia artificial y aprendizaje automático de OpenAI.

El equipo de investigación original que desarrolló el modelo GPT estuvo liderado por el doctor Alec Radford. También estuvieron Jeffrey Wu, Rewon Child, David Luan, Dario Amodei e Ilya Sutskever.

¿Cuál es el futuro de las IAs?

GPT: – La inteligencia artificial tiene un futuro prometedor y se espera que cause un gran impacto en diferentes áreas de nuestra vida. El aprendizaje profundo, el internet de las cosas, los asistentes virtuales, la automatización y la ética y seguridad son algunas de las tendencias y desarrollos que influirán en el futuro de la IAs. El aprendizaje profundo permitirá a las máquinas aprender y mejorar de manera autónoma y se utilizará cada vez más en la automatización de tareas en diferentes industrias; los asistentes virtuales se volverán más inteligentes y se espera que se implementen regulaciones para garantizar que estos programas se utilicen de manera responsable y segura.

¿Las IAs sustituirán trabajos humanos? ¿Cuáles?

GPT: – La inteligencia artificial puede reemplazar algunos trabajos humanos en el futuro, especialmente aquellos que implican tareas repetitivas y rutinarias. Se mencionan ejemplos de empleos que podrían ser sustituidos, como los de manufactura y ensamblaje, atención al cliente, conducción y transporte, y contabilidad y finanzas. Sin embargo, también se destaca que la IA puede crear nuevos puestos y oportunidades laborales en áreas como la programación y el análisis de datos. Además, siempre habrá actividades que requieran habilidades humanas únicas que no pueden ser reemplazadas por dichos programas. En resumen, es importante seguir evaluando y adaptándonos a medida que la tecnología continúa evolucionando.

¿Cuáles son los peligros de estas tecnologías?

GPT: – Aunque la inteligencia artificial puede ofrecer muchos beneficios, también presenta peligros y riesgos que deben ser considerados y abordados para su uso seguro y responsable. Algunos de los riesgos más comunes incluyen sesgos y discriminación, pérdida de trabajos, privacidad y seguridad de los datos, dependencia de la tecnología y uso de armas autónomas. Es importante que desarrolladores, usuarios y reguladores trabajen juntos para abordar estos peligros y garantizar su uso ético, seguro y responsable.

¿Estamos cerca de vivir como Sarah Connor?

Desde el imaginario nos parece que nos encontramos no a un paso del futuro, sino que ya llegó; que vienen robots a sacarnos nuestros trabajos; que las escenas de Terminator, Blade Runner y The Matrix están a la vuelta de la esquina, y podrían perfectamente ser parte de este movido 2023. Pero, ¿es realmente así? ¿En qué momento estamos?

Para responder a estas preguntas nos comunicamos con Julio Paciello, ingeniero, profesor e investigador del Departamento de Informática de la Facultad Politécnica de la Universidad Nacional de Asunción (UNA). Él investiga sobre software engineering e inteligencias artificiales.

Según explica el investigador, lo primero que debemos hacer es diferenciar entre IA débil y fuerte. La primera serían modelos computacionales que, si bien están dotados de programas que les permiten aprender, por ejemplo a partir de datos o experiencias previas, no presentan aún capacidades de automejorarse, es decir, no tienen la autonomía para extender sus propios límites o crear nuevos modelos.

En cambio, la Strong AI o fuerte es aquella que, aparte de la autonomía de aprendizaje, también ya está dotada de autonomía de mejoras, en hardware y software de su modelo; y busca “singularidad tecnológica”, es decir, capacidad de automejorarse: “Si bien es la Strong AI el destino al cual se apunta, hay que aclarar que aún estamos trabajando, incluso con ChatGPT y todo, con modelos de Weak AI”.

Pero no creamos que esto queda allí. Según Paciello, el grupo Deepmind, de Google y OpenAI, creado por un mix entre Elon Musk (aunque ya no forma parte de la junta directiva), Microsoft y otros, que sabemos representan las compañías más poderosas a nivel mundial en cuanto a tecnología y poder de cómputo, sí están yendo más allá de la Weak AI.

«Hoy son los pioneros en publicar productos con capacidades de refuerzo humano que permiten mejorar las versiones, e intentan también ir hacia esa IA general multidisciplinaria. El ejemplo contundente es ChatGPT, un modelo de aprendizaje profundo que podríamos considerar débil aún, pero dotado de capacidades de refuerzo humano para automejora, que aquí va caminando de lo Weak hacia lo Strong”, indica el especialista.

Volvamos a nuestro país. En Paraguay, entonces, ¿cuáles son los campos en desarrollo? “Aquí hay equipos de investigación en la UNA que están haciendo detección de patrones de enfermedades mediante el análisis de imágenes médicas, tareas de fintech como riesgo crediticio y de cobranzas, chatbots asistentes virtuales y data science que, en muchos casos, introduce modelos predictivos, y ahí es donde roza con las IAs”, detalla Paciello.

Para dar el primer puntapié a la conversación sobre las dimensiones éticas, Julio afirmó que la IA debe tomar decisiones justas e inclusivas para el bien global, pero está sujeta a sesgos en su etapa de entrenamiento, que pueden afectar su toma de decisiones. Es importante asegurarse de que el entrenamiento sea equitativo y libre de prejuicios para evitar decisiones discriminatorias.

Un ejemplo claro es ChatGPT, que está entrenado con datos hasta el 2020, lo que puede hacer que tenga sesgos cognitivos, culturales y estadísticos. Si se le pregunta algo posterior a dicho año, es posible que refleje eso. Por lo tanto, es importante garantizar la transparencia y la inteligibilidad de la máquina para asegurar que el IA sea ética. Además, según Paciello, ChatGPT todavía tiene bastantes dificultades en la creación de contenido debido a la infracción de derechos de autor y la filtración de noticias falsas.

Es fundamental ampliar las leyes para incorporar decisiones autónomas tomadas por computadoras, como en autos que se manejan solos o sistemas de análisis criminal utilizados en decisiones judiciales. Es necesario replantear las leyes para establecer responsabilidades en caso de errores en la toma de decisiones de la IA. La Unión Europea abrió este debate, publicó leyes sobre el tema y generó uno de los primeros grupos de trabajo en ética y legislación.

Tecnología y marketing

Para desarrollar una inteligencia artificial, el primer paso es definir el problema y, posteriormente, recopilar datos para entrenar el modelo. “Afortunadamente, empresas líderes en el mercado han simplificado mucho estos procesos y los pasos siguientes en el desarrollo de funcionalidades basadas en IA”, plantea Samuel Giubi, licenciado en Análisis de Sistemas Informáticos, orientado a las tecnologías enfocadas a los negocios y cofundador de la agencia web Porta.

Esta agencia se enfoca en mejorar el comercio electrónico con soluciones basadas en IA y, además, están en proceso de desarrollo de una plataforma gratuita y pública para crear currículums con ayuda de inteligencia artificial.

Ahora, la integración con servicios de IA ayuda a explorar y alcanzar nuevos niveles. Según afirma el licenciado, esta tiene una amplia variedad de aplicaciones en campos como la medicina, la banca, el comercio electrónico, la manufactura y la logística, por nombrar algunos ejemplos. En el campo del e-commerce, por ejemplo, se puede utilizar para mejorar la experiencia del usuario en la tienda en línea, automatizar la atención al cliente y optimizar el marketing y las ventas.

Las aplicaciones de la IA son variadas y amplias. Giubi sostiene que algunas de las claves serían la automatización de procesos, la mejora de experiencia del usuario, la optimización de marketing y ventas, la mejora de la atención y el diagnóstico médicos, y un amplio abanico en seguridad.

¿Existe neutralidad en el desarrollo de tecnologías?

La tecnología en sí misma no es inherentemente neutral, sino que refleja los valores, intereses y prejuicios de quienes la crean y la utilizan. Por lo tanto, las decisiones que se toman en el proceso de diseño y desarrollo de una tecnología pueden tener un impacto significativo socialmente, en cuanto a quiénes se benefician o se ven perjudicados por ella.

Maricarmen Sequera es codirectora de Tedic, una oenegé que desarrolla tecnología cívica abierta y defiende los derechos digitales por una cultura libre en internet. Ella se especializa en derechos digitales, privacidad y seguridad, así como ley cibernética, propiedad intelectual y software libre.

“Como humanidad estamos en una etapa pronato de la inteligencia artificial, más o menos. Todavía no estamos viendo ese robot asesino de las películas que viene a conquistar el mundo”, y continúa: “Es muy interesante para entender ese proceso que esta tecnología nunca va a ser perfecta, debemos humanizarla y reconocer que estará colaborando en nuestro día a día”.

“Hay unas zonas grises dentro de esa caja negra, que se alimenta de esa información, y esa información incluye no solamente datos públicos, sino también personales”, destaca Maricarmen. Podrían tener sesgos de confirmación o incluso problemas de interpretación. “Además, es posible que esos datos personales estén contaminados, sean erróneos o incompletos”, agrega.

Por otro lado, la investigadora hace énfasis en la automatización de algunos procesos, por ejemplo, en la identificación de las personas: “Con la información incorrecta, podría obstruir el acceso a ciertos contenidos o incluso a derechos”. Ya sucede en análisis crediticios, por ejemplo, y la situación se agravaría en caso de implementarla en cuestiones como la Justicia.

La inteligencia artificial está en un proceso todavía básico, pero ya es una caja negra. No sabemos a qué conclusiones va a llegar. “Las líneas de códigos no son transparentes, entonces ignoramos cómo arriban a esos cómputos de información”, sostiene Sequera.

Otro elemento importante para analizar es el sesgo en temas de construcción de la tecnología. Maricarmen dice que “a veces creemos que las IAs reemplazarán nuestros trabajos; no lo creo, pero pueden hacer algunas cosas más fáciles”, lo que llevaría a un proceso de profesionalización.

Pero la tecnología no llega a todos por igual. “En países del sur global como el nuestro, nos encontramos muy desconectados”, refiere la especialista. El acceso a internet no está disponible para todos: pensemos en las comunidades rurales o inclusive en las zonas ribereñas que no tienen este servicio. Además, también es importante mencionar las conexiones precarias a la red.

“Tenemos problemas de entrenar a un algoritmo, lo cual hace que nos excluya porque no va a saber qué cosas nosotros somos, cuáles son nuestros intereses y necesidades”, advierte Sequera. “Cuando viene una aplicación o una plataforma del norte global, hace automáticamente un proceso bajo los mismos parámetros de comportamiento cultural que tienen en esos países, y ahí es donde se nos excluye”, destaca.

Podría haber falta de información con respecto a nuestra región y sin dudas una visión sesgada; además, es posible que discrimine a grupos vulnerables y a países periféricos como los nuestros. “Esa mirada política hay que tener para evaluar cuáles son nuestros derechos humanos que van a estar afectados por la utilización de ese tipo de tecnología”, sostiene Maricarmen.

“Debemos preguntarnos primero por qué queremos usar esa inteligencia artificial, esa caja con falta de transparencia algorítmica y esa falta de rendición de cuentas de cómo funciona, para saber en qué proceso cualquier automatización nos pueda servir”, plantea Maricarmen. “Para mí, bienvenida sea la inteligencia artificial”, dice la especialista, pero advierte: “Es necesario entender y pensar en derechos primero, antes de hablar de datos personales; debemos analizar cómo se construye esa tecnología”.

Cuando hablamos de una plataforma o herramienta que provee un servicio de asistencia o ayuda, la mayoría de las veces es feminizada. “Incluso en este tipo de tecnologías que están ayudando cuando construimos culturalmente para qué va a servir, hay que pensar también políticamente”, observa Sequera.

Entre risas, Maricarmen plantea que el problema de la inteligencia artificial no es que venga un robot a atacarnos. “Son justamente esas cosas que no se ven las que excluyen de acceder a la tecnología o a ciertos servicios públicos y privados. Son rangos de errores muy mínimos y casi invisibles, pero muy problemáticos”, sostiene.

Por eso, las IAs deben estar pensadas en nuestros contextos y no con una receta del norte global que no sabemos si podría ser funcional en la región. “En todo caso, debemos armonizar o generar una plataforma o una solución tecnológica más acorde a nuestras necesidades. ¿Para qué? Para que no nos excluyan”, finaliza Sequera.

¿Un nuevo mundo?

Las tecnologías de inteligencia artificial podrían crear nuevas configuraciones sociales e históricas que llegarían hasta nuestras vidas cotidianas. “Me gustaría utilizar el término tecnoceno, de la pensadora argentina Flavia Costa, para referirme a lo que sucede en nuestra época”, explica Raúl Acevedo, docente investigador de la carrera de Filosofía en la UNA.

Según explica el filósofo, Costa sostiene que nuestra época, la del tecnoceno, es la “puesta en marcha de tecnologías de alta complejidad y altísimo riesgo”, que dejan huellas en el mundo en nuestra actualidad y tienen efectos para el futuro, como por ejemplo el accidente nuclear de Chernobyl.

Sobre las IAs se han dicho muchas cosas y la premisa sci-fi de que las máquinas se rebelarán contra la humanidad están a la orden del día. “Se presenta un panorama apocalíptico sobre los avances tecnológicos, y en específico sobre la IA, pero me parece que tal perspectiva es muy simplista”, sostiene Acevedo. El caso es que ya forma parte de nuestras vidas: “Algo ha cambiado y para eso debemos estar preparados; y, tal vez, la filosofía debería tomar partido”.

Hoy hablamos en términos de una distopía tecnológica, pero no necesariamente debe ser de esa manera. “Esa visión distópica carga ciertos prejuicios que tienen que ver con un ‘humanismo fácil’, como diría Gilbert Simondon; separan la tecnología de la cultura, y estas no deberían estar aparte, sino que debemos comprender su funcionamiento e implementación”, destaca Raúl.

La información cotiza en bolsa y el mercado de datos es uno de los más poderosos a nivel mundial. “Hoy, los avances tecnológicos cumplen un papel crucial en el nuevo modelo económico, y en específico la información que damos o cedemos en internet”, cuestiona el filósofo y sigue: “Los datos almacenados que dejamos, al utilizar Facebook, Instagram o Twitter, pueden servir para muchas cosas. Existe una ‘minería’ aplicada a la big data para perfilar y realizar trabajos estadísticos que sirven a empresas, por ejemplo”.

“Pensar desde una perspectiva ética, me parece, implica analizar los efectos que los avances tecnológicos, y con ellos la IA, traen consigo. No quiero caer ni en la tecnofilia ni en la tecnofobia, que me parecen los caminos más fáciles de seguir, sino asumir el desafío de pensar colectivamente todos los cambios que nos traen”, interpela el investigador. “Tomar una postura ética, para mí, es poder comprender nuestra realidad compleja y, como decía Flavia Costa, con lo mejor de la imaginación social, cultural y política”.

Durante la semana se divulgó una carta abierta de magnates y grandes investigadores de tecnología —Musk, Harari, Russel, Bengio, entre otros— en la cual solicitan parar el entrenamiento de sistemas de inteligencia artificial más potentes que GPT-4 al menos por seis meses, por seguridad y “para evitar un shock social violento”. Suena a que la carrera tecnológica ya empezó. Mientras tanto, podemos usarla para hacer simpáticas imágenes del Papa con abrigos vistosos o que ChatGTP recree guiones de series con personajes paraguayos.

Sin Comentarios