¿Qué pasa con mi algoritmo?

En esta entrega de ¿Qué pasa con mi algoritmo? hacemos un recorrido por los sesgos ocultos en la inteligencia artificial, desde la lingüística hasta la ética. ¿Existe realmente la neutralidad tecnológica? ¿Cómo evitar que refleje —y potencie— los prejuicios incrustados en nuestro lenguaje, datos y sociedad?

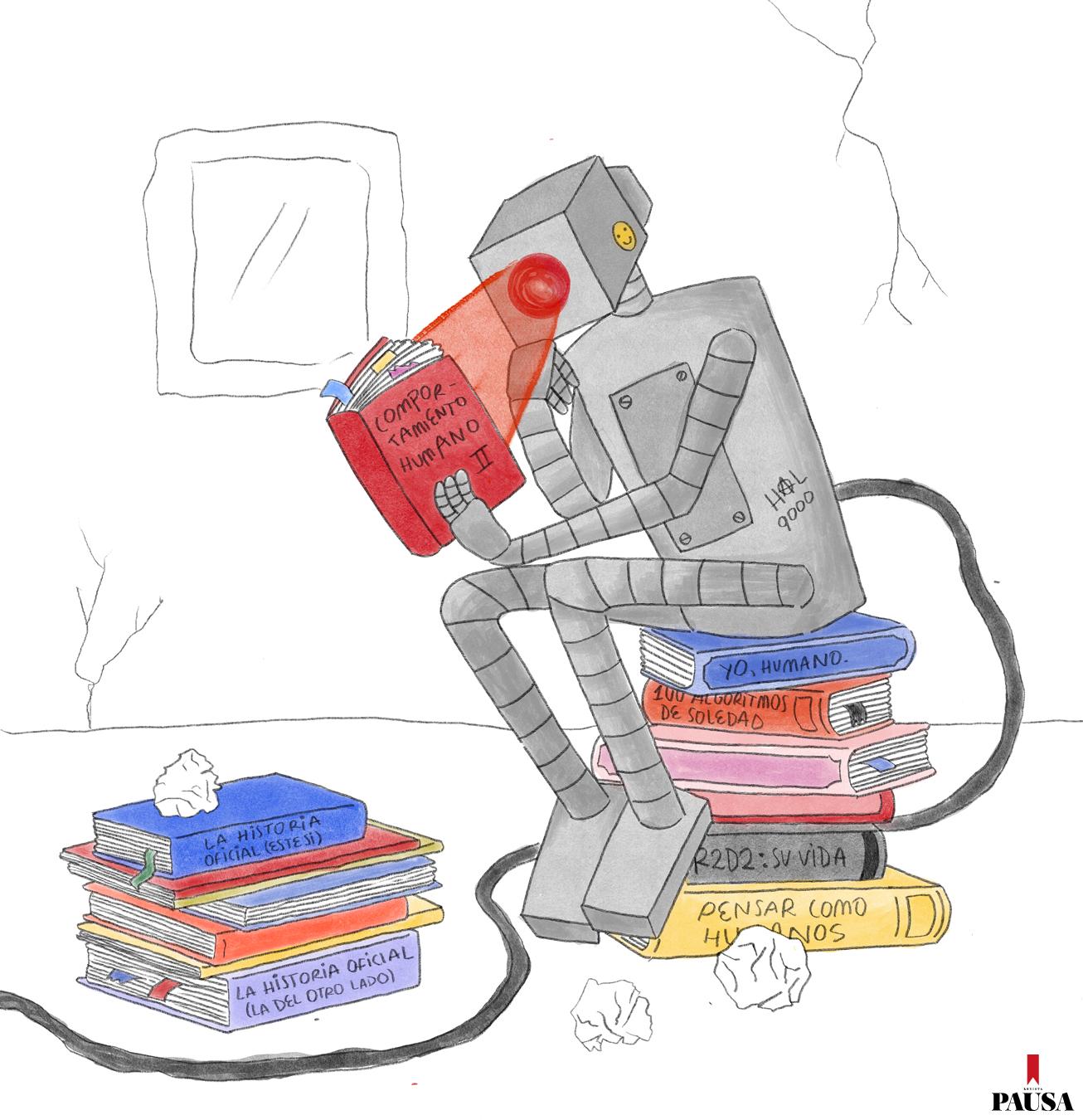

Por Laura Ruiz Díaz. Ilustración: Macarena Ibarra (@juanadebarro).

El semiólogo y filósofo suizo Ferdinand de Saussure, padre de la lingüística estructural del siglo XX, plantea en su Curso de lingüística general su definición de signo, que se forma a su vez por un significado y un significante. El significante podría ser la palabra “mesa”, mientras que el significado es la idea de la mesa que cada uno imagina.

Pero hay tantas mesas como personas. Mientras quienes me leen quizás piensen en una de madera, yo, que escribo en un escritorio de melamina, podría tener ese material en mente. Esta reflexión nos sirve de introducción a una cuestión clave: todas las palabras, en su significado, cargan con una visión de mundo.

Las palabras tienen cargas semánticas, connotan. Según la lingüista Catherine Kerbrat-Orecchioni, la connotación es el significado implícito y subjetivo de un término, que va más allá de lo literal (denotación) y se construye a partir de factores sociales, emocionales e ideológicos. En el modelo que ella propone en su texto La enunciación, la connotación está vinculada a los “filtros” del emisor y el receptor (lingüísticos, paralingüísticos, ideológicos, culturales y psicológicos).

Todas estas cargas, nosotros, como hablantes, las intuimos al interactuar y comunicarnos. Pero, ¿qué pasa cuando nos relacionamos con un sistema algorítmico, como los modelos de procesamiento de lenguaje natural (PLN)? A saber: Gemini, ChatGPT, DeepSeek y un largo etcétera.

Las herramientas de PLN funcionan de la siguiente manera: reciben una gran cantidad de datos que se procesan casi de forma automática y siguen una secuencia de pasos para permitir que una computadora lea, comprenda e interprete el lenguaje humano, ya sea texto o voz. Este proceso se basa en una combinación de lingüística computacional y algoritmos de machine learning (aprendizaje automático).

Hasta allí vamos bien. Ahora, ¿qué pasa cuando una IA es la encargada de hacer un análisis crediticio o seleccionar a los mejores candidatos para un trabajo? ¿Qué seleccionará y con base en qué criterios? Ahí es donde la cosa se pone un poco más compleja. Porque, en primer lugar, se alimenta de una base de datos, que, como mencionamos anteriormente, está cargada de significados. Segundo, fue programada por un grupo de personas, generalmente del norte global, que no vive en nuestros contextos, y cada una de ellas piensa de una manera. Y tercero, que está expuesta a nuestra propia subjetividad como usuarios. A todo esto se le denomina sesgo. O bias, en inglés. Esta terminología posee muchas acepciones, pero en estadística tiene que ver con un “error de cálculo” en cuanto a la objetividad del analista o de los datos.

En modelos de lenguaje se han identificado sesgos en varias investigaciones, según cita el artículo Exploring Stereotypes and Biases in Language Technologies in Latin America, de Hernán Maina y otros. Por ejemplo, nutricionistas que estudiaban la percepción de una dieta saludable en las redes sociales encontraron una asociación sinonímica entre “feo” y “gordo” que era más fuerte para las formas femeninas que para las masculinas. Y la lista sigue, porque los estereotipos también.

Cabe preguntarnos si los sesgos no son más que prejuicios, también presentes en nuestras sociedades. Ese es el enfoque que investiga la lingüista e investigadora argentina Paula Serrano. En su artículo Eso que llamamos «sesgos», plantea que estos, en realidad, son esquemas de discriminación. Y lo fundamenta de la siguiente forma: “¿Es realmente un desvío con respecto a nuestra realidad social? ¿La IA le está fallando a la representación de la sociedad o la está copiando fielmente? Lo cierto es que gran parte de los problemas que el mundo tech entiende como ‘sesgos’ tienen su raíz en desigualdades sociales preexistentes”.

En el mismo texto, cita el artículo Artificial Intelligence, Algorithms, and Social Inequality… del sociólogo Mike Zajko, y describe los discursos actuales sobre tecnología algorítmica con dos puntos en común: una idea de inevitabilidad y de determinismo tecnológico y la pérdida de la agencia humana. Ambas alarmas desvían el foco de atención de lo que está pasando hoy y de la posibilidad real que tenemos de intervenir en el tema. “Los ‘sesgos’ que hay en nuestra sociedad son reproducidos por los sistemas automatizados. Y no se trata solo de una repetición del ‘desvío’ humano, sino de una multiplicación a gran escala: el aprendizaje automático y la gobernanza algorítmica suelen crear

feedback loops (bucles de retroalimentación) que replican y amplifican los patrones existentes en la sociedad”, plantea la autora.

Serrano presenta dos marcos conceptuales en pugna para definir los sesgos en la inteligencia artificial. La primera perspectiva, común en el campo técnico, entiende el sesgo como una desviación de la ground truth o “verdad fundamental” del mundo real. Bajo esta lógica, un modelo que replica las desigualdades e injusticias de nuestra sociedad no estaría sesgado, sino que sería precisamente exacto.

Frente a esto, Serrano, citando a Zajko, propone una segunda definición, más amplia y ética, que concibe el sesgo no como un error de precisión, sino como la reproducción de algo socialmente indeseable. Esta mirada revela el conflicto central: “La disputa entre precisión y deseo enmascara una pregunta filosófica y eminentemente ética: ¿Los algoritmos deberían reproducir la sociedad con precisión o contribuir a mejorarla? Y en todo caso, ¿cómo sería el mundo deseable?”. Para pensar.

QUIERO IDENTIFICAR SESGOS: ¿QUÉ HAGO?

EDIA es un proyecto de la fundación argentina Vía Libre cuyo objetivo es involucrar a más personas en la evaluación de tecnologías de inteligencia artificial, como los modelos de lenguaje. Esta herramienta busca explorar la IA desde un punto de vista social e interseccional con el objetivo principal de crear una primera alfabetización crítica en este tema. Podés encontrar más información en

ia.vialibre.org.ar

Sin Comentarios